Connaissez-vous les agrégateurs de flux en ligne ? Purs produits du web 2.0, il est possible que certains d’entre vous n’en aient pour l’instant que vaguement entendu parler, sans les utiliser. Mais ça ne saurait tarder : le succès de ces portails personnels croît exponentiellement, tout comme leurs possibilités.

Pour ma part, j’ai découvert le concept le jour où Google a lancé Google IG, son moteur de pages personnalisées. Simple, sobre, voire spartiate, je m’en suis très bien contenté pendant près d’une année. Au début limité aux seuls flux RSS, Atom fut assez vite implémenté, puis on a vu arriver les premiers gadgets comme Google Maps ainsi que les inévitables calendriers, dictionnaires, traducteurs ou jeux de sudoku. C’est lorsque les onglets ont été implémentés, en octobre dernier, que j’ai réellement commencé à m’organiser un portail personnel et à en faire ma page de démarrage et à en tripoter le code CSS pour le rendre plus agréable à regarder.

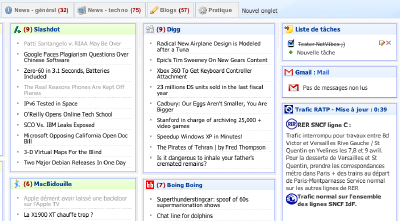

Et puis à la fin du mois dernier, j’ai découvert Netvibes grâce à une blog qui a toute ma confiance et qui en parlait. Pour résumer, c’était Google IG en mieux à tous les points de vue : bien plus joli, plus de possibilités et de réglages, des gadgets plus puissants et une communauté francophone existante. En un tournemain, je me crée un compte (un modèle de rapidité que cette opération sur ce site-là !) et me crée une page au contenu presque identique à mon portail Google d’alors. Puis vint le moment du choix : Netvibes était très tentant mais j’aimais beaucoup IG… ce qui m’a convaincu fut le module affichant les perturbations de la RATP et de la SNCF : utilisateur régulier des transports parisiens, il s’est vite révélé indispensable.

Puis, au bout de quelques jours, je me suis rendu compte d’un gros défaut de Netvibes : sa consommation mémoire. En effet, sur mon Mac, le fait d’afficher ma page (et ses 6 onglets, certes) affectaient d’office 100 Mo de RAM supplémentaires à Firefox ! Qui plus est, une fuite de mémoire (qui faisaient encore augmenter la taille occupée par Firefox) était également observable. En quelques heures, Firefox arrivait facilement à 250 Mo à lui tout seul… Ouille ! D’accord j’ai 2 Go de mémoire en tout, mais ce n’est pas une raison pour laisser mes programmes en faire n’importe quoi.

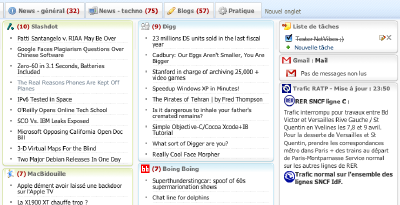

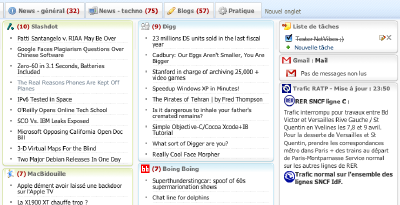

C’est ainsi que, dépité, je me suis demandé s’il fallait revenir à mon bon vieux IG, qui faisait pour moi partie du passé. Un peu comme revenir à Mac OS 9 après mes quatre ans sous Mac OS X, en quelque sorte. Je suis donc parti en chasse d’un remplaçant à Netvibes qui serait basé sur le même concept mais en plus léger. Après avoir visité plusieurs autres agrégateurs qui organisaient l’affichage d’une façon qui ne me convenait pas, j’ai fini par débarquer sur Pageflakes, qui semblait bien être ce que je cherchais. On y trouve en effet plein de points communs avec Netvibes, comme la création de compte ultra-rapide, les manipulations identiques ou les réglages possibles sur chaque module (ici nommés “flakes”).

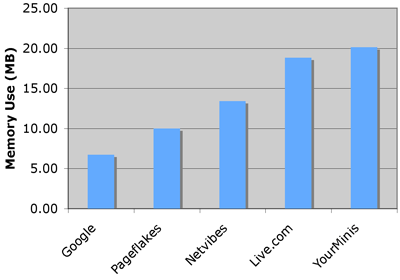

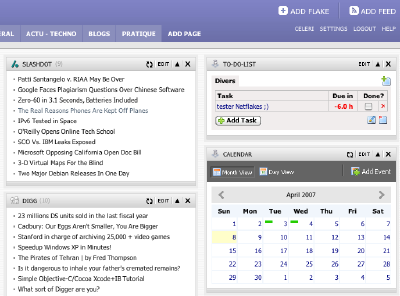

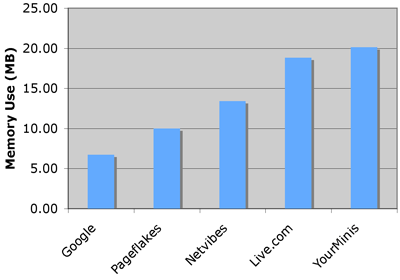

C’était il y a une semaine environ et Pageflakes m’a vite séduit : j’étais dans mon élément et même si mon module RATP-SNCF me manquait (triple argh), au moins mon Firefox restait raisonnablement gourmand. Jusqu’à aujourd’hui où je suis tombé sur une note de blog qui parlait des ressources consommées par différents agrégateurs et dont un document m’a interpellé :

On y voit clairement que Netvibes est moins gourmand que Pageflakes, et à peine plus que Google IG. Et les tests ont été menés sur un Powerbook très proche de la configuration de mon Mac : 2 Go de RAM, OS X 10.4, Firefox 2.0… qu’en penser ? Intrigué, je charge mes pages Google IG, Netvibes et Pageflakes au moyen d’un PC sous Windows et que je regarde la consommation mémoire de Firefox qui en résulte :

Google IG : 33 Mo

Netvibes : 35 Mo

Pageflakes : 40 Mo

Voilà qui confirme les valeurs obtenues par le site. Mais que ce soit sur mon Mac ou un autre, malgré toutes sortes de bidouilles (élimination des extensions, création d’un profil tout neuf, etc.), j’ai invariablement quelque chose qui ressemble à ceci :

Google IG : 70 Mo

Netvibes : 173 Mo

Pageflakes : 77 Mo

Autre détail important : le problème ne se manifeste qu’avec Firefox ; Safari, Opera, Camino sont, pour leur part, épargnés. On a donc ici un bug qui semble définitivement lié à la plate-forme Mac. Mais l’auteur du graphique ne semble pas être affecté, lui… Pourquoi, pourquoi, pourquoi ? Je regarde alors la date de l’article : décembre 2006. Entre cette date et aujourd’hui, Netvibes a un peu évolué : quelques options supplémentaires et un nouveau thème, nommé “Coriander”, activé par défaut. Hmm… l’intuition me suggère d’essayer de revenir au thème classique, puisque c’est faisable (et facilement, en quelques clics). Et là, miracle : Firefox revient à 72 Mo de mémoire consommés après avoir chargé ma page complète !

Voilà comment je suis en mesure d’affirmer aujourd’hui que cette sur-consommation de RAM occasionée par Netvibes a trois origines qui doivent être concomitantes :

– être sous Mac OS X

– utiliser Firefox

– avoir activé le thème “Coriander”

J’ai bien évidemment envoyé un rapport au staff de Netvibes, en espérant qu’il ne sera pas de ceux à répondre en substance “bonjour, la plate-forme Mac représente moins de 5% du marché, donc on s’en cogne…” En tout cas, en cet instant précis, je pense que je vais donc refaire de Netvibes ma page de démarrage : il est un peu moins joli qu’avant mais j’ai réussi à contourner ce qui semblait être son principal défaut. Et au moins, je retrouve mon module RATP-SNCF ! ;)